眼看着就要到春节了,这本来是个喜庆的时刻,但是不得不说,这也是每年诈骗的高发期,而且这两年情况更严峻了。为什么呢?因为很多骗子也开始用AI了。因此,今天我们请《科技参考》主理人卓克老师来说说怎样防骗。

简单来说,AI生成逼真的语音和视频,训练过程需要的数据更少,生成效果更逼真,但套路还是旧有的。诈骗的核心并不是AI生成的内容,而是引起当事人的恐慌,然后放下戒备开始乱猜乱想。

我们需要更精心地保护自己的特征数据。不过一切个人应对技巧都是杯水车薪的,主要还得靠AI的监管和金融和公安系统的联动。

01

骗局如何发生?

现在诈骗犯瞄准了一个28岁的年轻小伙子,骗他父母的钱。方案是量身定制的,这样的人会有哪些软肋呢?

就是在父母眼中属于到了结婚生子的年龄,父母也开始盼着抱孙子孙女了,而城市化的现实是,这个岁数的小伙子大都正在忙事业,还没有结婚,更没有小孩。

所以某天晚上,母亲手机突然有个陌生女人来加好友,妈妈给通过了。刚刚通过,微信视频电话就打过来,接起来一看,是自己的儿子,说:“妈,有个事儿我之前不好意思说,但现在不能不说了,我早就有女朋友了,都怀孕了,现在突然出了状况,救护车送到医院的,正在检查,能不能给我打2万块钱,非常急,我把汇款信息给您微信发过去了。”

还没等妈妈说话,电话挂了。妈妈看到之后,又惊喜又担心,这下不但婚事大概稳了,连孙子都快抱上了,但到底出了什么状况呢?这时赶紧给打了回去,对方没接,连打了2个都没接,赶紧给儿子微信打电话,如果偏巧这时儿子正在忙其他的,没看到手机,妈妈这会儿就慌了。

而那个陌生女人的号开始文字回复了,说不知道情况好坏,我在医院正忙着办手续呢,来不及回复,一会儿和您细说。妈妈看了这句话才稍微安稳一点。

等了5分钟之后,这个陌生女人的微信号又来视频电话了,接通之后画面非常卡,儿子说:“喂喂喂,妈妈能听到吗?能看到我吗?”然后好像嘴巴一直在说话,但画面和声音严重卡顿,几秒钟后视频又断了。妈妈再问,微信上回复就是信号不好,不用视频了,文字说吧。接着就是反复确认,汇款了没有。

骗子都做了哪些事?

好,我们让剧情暂停到这里,复盘一下这段剧情里骗子在做什么?

首先是制作深度伪造的合成视频。

那个小伙子可能是一个视频博主,网上有他的vlog,为了接广告留下的商业合作信息,姓名、电话、微信都是现成的,所以数据和人就对上了。

那这个小伙子父母的微信,骗子是怎么知道的呢?

今天在暗网上有大量快递信息打包数据,有的是没有整理过的,有的是对关系做过整理的。所以甚至可以直接看到这个小伙子的常住地、办公地、老家、父母的手机号、曾经给父母买过什么东西,都是比较全的。而且很多人的微信,是可以通过直接搜手机号搜到的。

于是诈骗犯就能通过这样的方式,锁定一个有视频可以当作训练数据的人,和他的父母的手机号与微信号。

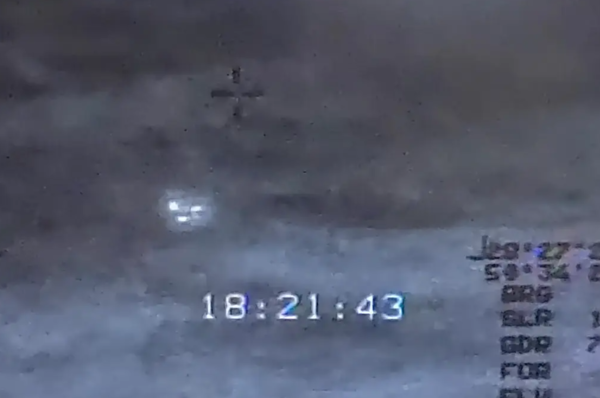

然后他们用魔改版的微信,串流的方式把事先做好的深度伪造视频当作视频电话的数据推给妈妈,妈妈那边是正常接电话,实际是在播放一段录制好的视频。

这条视频的作用是把需求说清,并建立基本的信任,让妈妈知道有这么一回事。但由于这是播放事先做好的视频,所以电话里是不能沟通交流的,于是视频要短,十几秒,把事情说完赶紧挂断。

接着诈骗犯知道妈妈肯定会把电话打回来,于是准备一些话术,比如现在脱不开身,一会儿细说。

间隔几分钟后,再给妈妈打第二个微信视频电话,这次推流推的就是第二段只有几秒钟的视频,而且这个视频是特别卡顿的。这几秒钟的视频也是事先做好的,就是要做成声音和图像都卡顿的效果,甚至会添加画面撕裂效果,只是说“喂喂喂,听得见吗,看得见我吗”,然后再卡顿一些根本听不出什么话的内容,几秒钟后关断通话。

后续就只在微信里催促汇款,诈骗就差不多完成了。

其实第二段卡顿视频尽管时长特别短,也完全没有说任何实质性内容,但它在整个诈骗环节起的作用是最大的。

父母分几种情况。

第一种,马上就信了,赶紧给账号转账,诈骗就完成了。这个咱们不多说。

第二种是没有马上转账,而是去和儿子的亲戚、朋友、同学、老师、同事核实儿子当前的状况。

因为自始至终妈妈都没有直接和儿子联系到,都是通过那个陌生账号看到儿子的2个视频和若干文字。所以心里的担忧会不断增加。甚至还有经验更老道的家长,比如像我一样,我知道AI领域存在深伪视频欺诈的事情,通过微信要钱都是不靠谱的,内心早已拉响了警报,等我儿子长大了,我即使有这样的知识和经验,等这种事发生在我身上,我照样也会破防的。

我最初的反应是什么呢?就是跟刚加的那个微信号说,钱我可以给你转过去,但你把视频打开,让我看看你和你女朋友的合影,网络不好也没事,你把你们之前的合影发我几张,或者我会问他,咱家养的狗叫什么名字?

对于真儿子来说,这些要求都是轻松过关的,但对诈骗犯来说就无法提供了。

你以为这样就能轻松应对了吗?不是的,因为你不是当事人父母,为人父母天生就有最大的软肋。

于是第二段视频也卡,音频也卡,只有几秒钟的微信电话就非常有用。

大部分父母会乱了方寸,开始过度解读,比如:我儿子别是有难处不方便直说,拿什么女朋友怀孕当挡箭牌吧?我儿子怎么穿了件绿色宽大的T恤,是不是他也要跟他女朋友一起进手术室?别不是怀孕吧,是不是要捐肾给她啊?还有我儿子第二段视频后面怎么是个小门啊,他被绑架了吧?不能明说,只能找借口要钱,这是不是在威胁下打的?手指头有没有被砍掉?人还在不在国内?这些担忧甚至远超过诈骗犯设计的范围。

这时我们再看网上教人怎么识别深伪视频的小技巧,比如看他嘴部动作有没有不自然,看他瞳孔里的白色亮点是不是指的同一个方向,看他头发末端是不是上面细下面粗等等等等。你发现没有,全都没用。

因为这是两通微信视频通话,挂了电话就没有视频了,你怎么可能第一次就注意得到那些细节呢,等你想核对细节时,早就没有机会了。

03

深度伪造视频是怎么生成的?

我们再说说深伪视频是怎么生成的。

简单地说,今天的AI世界存在一个不对等的发展,就是关于如何生成高质量文本、音频、视频技术的论文、研究的数量,远远超过如何识别这些内容是否是AI生成的研究数量。所以任何网上提到的分别深伪视频的小贴士、小技巧、绝招,都会在很短时间里失效,具体多短?最多半年就会过期了。

我们可以找到很多2024年初和AI换脸、换声音有关的内容。

以声音来说,2024年初,想要直接从文字生成语音,而且是高度模仿一个人的嗓音,至少需要30分钟那个人的嗓音作为训练素材。

如今,在要求不高的情况下,比如只生成10秒钟以内一个人逼真的嗓音,最短只需要3秒钟真实语音就足够训练了。如果能捕捉到更长的语音,比如说1分钟长度的一个说话的声音,那训练后,从文字生成的语音质量就已经可以达到熟人听了真假难辨的地步。

最初我看网上有人评论:“你看,那些做视频的,尤其是镜头怼着脸说啊说的up主们,你们给诈骗犯提供了最好的训练数据。”因为一个几百万粉丝的大V,正脸、侧脸、口腔内部、手部动作,可供训练的视频数据、音频数据太丰富了,至少十几个小时。所以真要是有诈骗犯瞄准这些大V,起码生成的深伪视频质量是有保障的。

但如今视频方面可能还有些门槛,但音频想仿造,门槛实在太低了,3-5秒钟足矣。

不怕贼偷,就怕贼惦记,如果你已经被惦记上了,然后他用虚拟运营商号码给你打电话,你接起来,那边不说话,或者故意说错话。

比如“我是某平台清洗空调的,约好了时间,怎么家里没人啊。”然后你一脸迷茫,什么清洗空调,我没约过啊。或者电话打来,说:“你下来挪车,把我车挡住了。”然后你也一脸迷茫,我家车停在车位里呢,怎么可能挡住别人。就在和对方解释时,语音数据就已经超过10秒了,足够用了。

视频数据别看还没有很低的门槛,但生成式技术的进步,不久之后甚至可以通过一个人几张静态的照片,AI可以给我们脑补出这个人演讲、跑步、生病的动态片段。

到时候骗子说不定也用不着提前录视频了,直接拨通微信视频电话,实时生成高质量的变脸、变声。于是父母更不会怀疑了,你想,真人在屏幕里和你一问一答,怎么可能是假的?

今天虽然实时生成视频还不行,但音频已经可以了。

于是,在领导与下属、男朋友和女朋友、名人和粉丝之间、投资圈里的杀猪盘等等就会层出不穷。

前两年,靳东加你微信好友,曾经是直播界的一个梗,就是在直播打赏上头后,中老年女性被诈骗犯利用了。

而且即将成熟的agent智能体也会被用在更多样性的诈骗中,让本来不具备编程和网络技术的诈骗犯也能大施拳脚。甚至让他们可以不用只骗和自己母语一致的人。agent可以从目标分析开始选定受害对象,对其做画像分析和针对性的个性化钓鱼剧情设计,然后生成多模态(语音、视频等等)的各种素材和诈骗方案。

04

个人防范,步骤多很麻烦

你要真想防范,可能步骤还得再往前提。

也就是所有网络身份,都用笔名、化名。包括京东、淘宝的快递,比如我现在都改叫“香蕉树上看你笑”。

私下亲朋好友沟通时,只用私人手机号和微信号,而工作、外卖、快递、办手续都用另外一个手机号和微信号。截然分开就不容易被分析出人物的关联。父母关心则乱的软肋就不会被利用上。

但说到底,深伪视频是无法阻挡的,之后一定会越来越逼真,制造成本也会越来越低。识别和防范技巧只适用于极少数的达人,因为它要求当事人特别不怕麻烦,随时保持警惕。而99.9%的人是做不到的,哪怕知道有好处也懒得做。

05

大平台和政府监管

于是,想防范不断升级的AI欺诈,一是要靠大平台推出的内置在软件或者硬件上的防范,二是要靠政府及时更新监管条款。

今天有些手机操作系统自带可以识别AI合成声的功能,打开后,只要是AI合成语音打来电话,界面就会标红,告诉你:此声音来自AI合成,请警惕诈骗。

当然,今后也可以对具体内容做鉴别,提示这些语音内容可能包含诈骗。在我们听对方说话的时候,你手机上会自动降低对方音量,然后提高本地提示音,告诉你:这通电话内容高度疑似诈骗。

此外还得指望着国家法律法规不断更新,比如所有生成式功能的平台和软件都需要备案、可追溯、有标签等等。

虽然不法分子最后会想办法自己部署服务器用于训练,但起码防住了那些诈骗启动资金小于1000万的骗子们。

大平台和政府监管对生成式AI及时更新防范措施,才是防止AI欺诈的绝对主力。

高效的监管又有前提,就是在生成式AI的发展中,不能只发展生成式的技术,也要发展AI识别上的技术。这方面比较有代表性的活动是2024年上海举办的全球DeepFake(深度伪造技术)攻防挑战赛。

其实识别上做到90分的水平,比生成上做到90分要容易得多,因为我们知道怎么生成全部细节,那么对于生成后的内容有哪些数据特征、算法特征,都是识别算法很好的提示。

今后这些技术内置在微信、飞书里,才会把AI诈骗的渠道大部分堵死,我们普通人也就不用费尽心思学识别技巧了。

| 当前新闻共有0条评论 | 微信扫一扫 | ||

| 分享朋友圈 |